AI 輔助設計完整指南:彰化中小企業實戰攻略與ROI計算模板

10月 21, 2025

2025多語言SEO終極指南:從雲林出發攻佔亞洲市場的實戰策略

10月 22, 2025

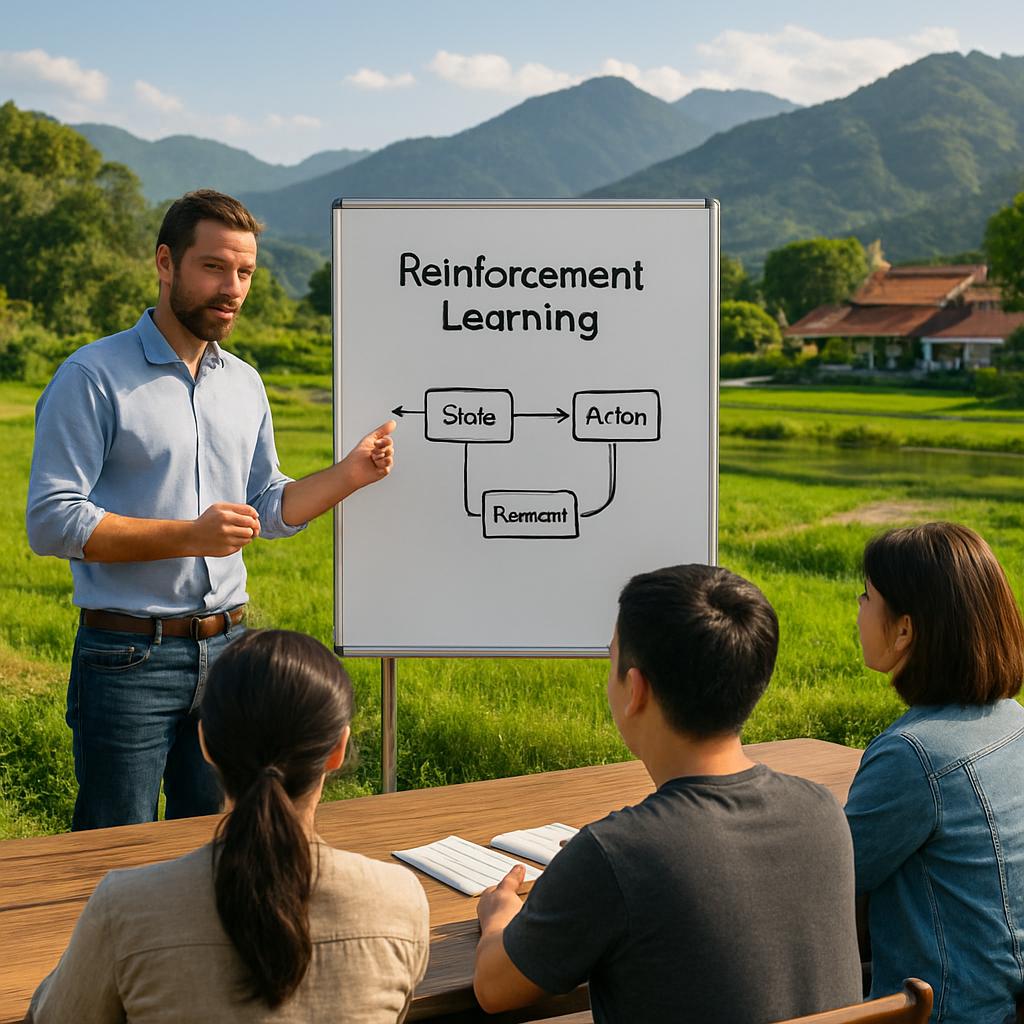

2025 最新|強化學習 Reinforcement Learning 完整指南:從基礎到進階實作教學(台灣與南投縣案例)

從頂會到產線,強化學習 Reinforcement Learning 正把決策自動化帶進主流。Nature 的深度強化學習研究已成里程碑,學術與產業鏈的最佳實務逐漸匯流(參考:Nature:Deep Reinforcement Learning 里程碑研究)。你是否也卡在「理論看懂了,專案卻落不了地」的痛點?本指南以台灣與南投縣情境出發,帶你走過「概念→實作→部署→治理」全流程,並提供在地化案例與實用清單,幫助你把強化學習從實驗室帶到生產環境。

📋 重點摘要

- 以 MDP 為核心模型,先離線驗證再小流量在線探索

- 在地落地以低成本、高回饋情境優先(觀光、農業、教育)

- 治理與監控為上線成功的關鍵:漂移檢測與回滾機制

- 從 Q-learning → DQN → PPO,按空間與觀測決定選型

用一條龍落地法拆解:強化學習從 MDP 到上線監控(台灣案例)

強化學習的落地不只靠演算法,更是流程管理與治理佈局。建議依序執行問題建模、環境定義、獎勵設計、基線演算法、訓練策略、評估與上線、最後導入監控與治理。

實務上先用模擬器或歷史紀錄做離線迭代,避免風險;獎勵設計應由業務指標倒推,並加入中間獎勵與懲罰以避免「刷分」。具體資源與案例詳見 南投AI應用,可作為本地化參考。

- 問題建模(MDP):定義狀態 S、動作 A、獎勵 R 與轉移機率。

- 基線演算法:表格型 Q-learning 與 SARSA 做驗證,影像或連續控制用 DQN / PPO。

- 訓練策略與治理:先離線 RL 與行為克隆暖啟動,再小流量在線探索與分層上線。

💡 專業提示

先做「無悔」版策略:限制高風險動作集合,保留行為日誌與版本控制,便於審核與回滾。

南投縣在地導入藍圖:強化學習在教育與觀光農業的輕量起手式

南投縣具教育數位化基礎與活躍社群,適合以低成本、高回饋情境切入,再逐步擴展。優先鎖定決策頻繁且回饋可量化的用例,例如智慧茶園、觀光導覽、庫存管理與自適應教學。

實作要點包含雲端 Notebook、模擬器資料生成與在地工作坊;初期以小規模迭代驗證成效,並逐步建立資料授權與家長同意等治理原則。參考在地農業導入資源:智慧農業指南.

- 智慧茶園/咖啡烘焙:代理人學習烘焙曲線與灌溉策略,獎勵結合杯測評分與產量品質。

- 觀光導覽與動態定價:以滿意度與停留時間設計複合獎勵,優化動線與收益。

- 教育場域:自適應練習,將學習成效與投入度納入獎勵,避免只追求完成率。

⚠️ 風險提示

在教育與消費情境特別注意公平性與資料同意流程,須事先取得家長同意並建立成效與公平性評估指標。

進階實作:從 Q-learning 到 PPO,以及強化學習 × LLM 部署心法

當你能在簡化環境穩定收斂,即可向高維觀測與複雜策略進階。選型上,離散小空間以 Q-learning 起步;影像或大狀態則用 DQN;連續控制與穩定優先情境推薦 PPO。

訓練穩定技術包含梯度裁剪、學習率退火與觀測標準化;部署上採灰度放量、策略上限與回滾機制。進一步的 RL × LLM 組合可用行為克隆蒐集高質量軌跡,再用 RLAIF/RLHF 做偏好對齊,相關繁體中文 NLP 實作參考 繁中NLP實作.

想補強理論基礎與課程內容,可參考 Stanford CS234 課程,作為研究與產學接軌的橋樑。

よくある質問

問:強化學習是什麼?和監督/非監督學習有何不同?

答:強化學習讓代理人在環境中透過回饋學策略,以最大化長期回報。不同於監督學習依賴標註資料,強化學習強調序列決策與時序依賴,適合遊戲、控制與營運優化等場景。實用建議:先用簡化環境驗證可學性,再做灰度上線以降低風險。

問:在台灣/南投,哪些情境最適合先導入?

答:觀光流量分配、農產製程調參、教育自適應練習與中小企業庫存補貨是優先項目。這些場景決策頻繁、回饋可量化且單筆風險低,便於快速迭代。實用建議:從離線 RL 與行為克隆暖啟動,再做小範圍在線探索。

問:獎勵函數如何避免「刷分」與稀疏獎勵?

答:使用中間獎勵、負獎懲罰與分層課程學習,並拆解長期 KPI 成可觀測的子目標。範例:將訂單履約率拆為接單速度、庫存可用率與配送準確度三個子指標分別回饋。實用建議:每次只改一個獎勵項並畫學習曲線與 Ablation 分析。

問:我要選 Q-learning、DQN 還是 PPO?

答:原則為:小離散空間選 Q-learning;高維離散(影像)選 DQN;連續控制或需要穩定性的情境選 PPO。建議先跑兩種簡單基線,選擇收斂穩定且易解釋者再精調超參數。

問:資料不足怎麼辦?可以用模擬或離線資料嗎?

答:可以,常見流程是先用模擬或歷史軌跡做離線 RL,再逐步放量在線上測試。建立環境模擬器與數位分身,並使用經驗回放與模型式方法提升樣本效率。實用建議:設定可信度評分與風險閥值,逐步提高在線探索比例。

問:如何部署並監控 RL 模型?

答:採灰度放量搭配多層保護欄:熔斷、回滾、策略版本化與人審流程。監控指標包含回報、業務 KPI、策略熵、違規率與資料漂移。更多合規與在地實務建議可參考 AI倫理指南,並以 SLO 設定告警門檻,異常時自動切回安全策略。

結論:強化學習的自然出現

若以流程化落地執行,強化學習 Reinforcement Learning 能在台灣與南投縣的實務場景快速產生價值。建議從小型可控用例開始,結合模擬、離線驗證與嚴謹治理,再逐步放量上線。若需進一步協助,振禾行銷可提供 Notebook、程式碼審閱與部署治理指引,幫助你完成第一個可上線的強化學習專案。